突破极限!NVLM 1.0引领多模态AI革命,超越GPT-4o!

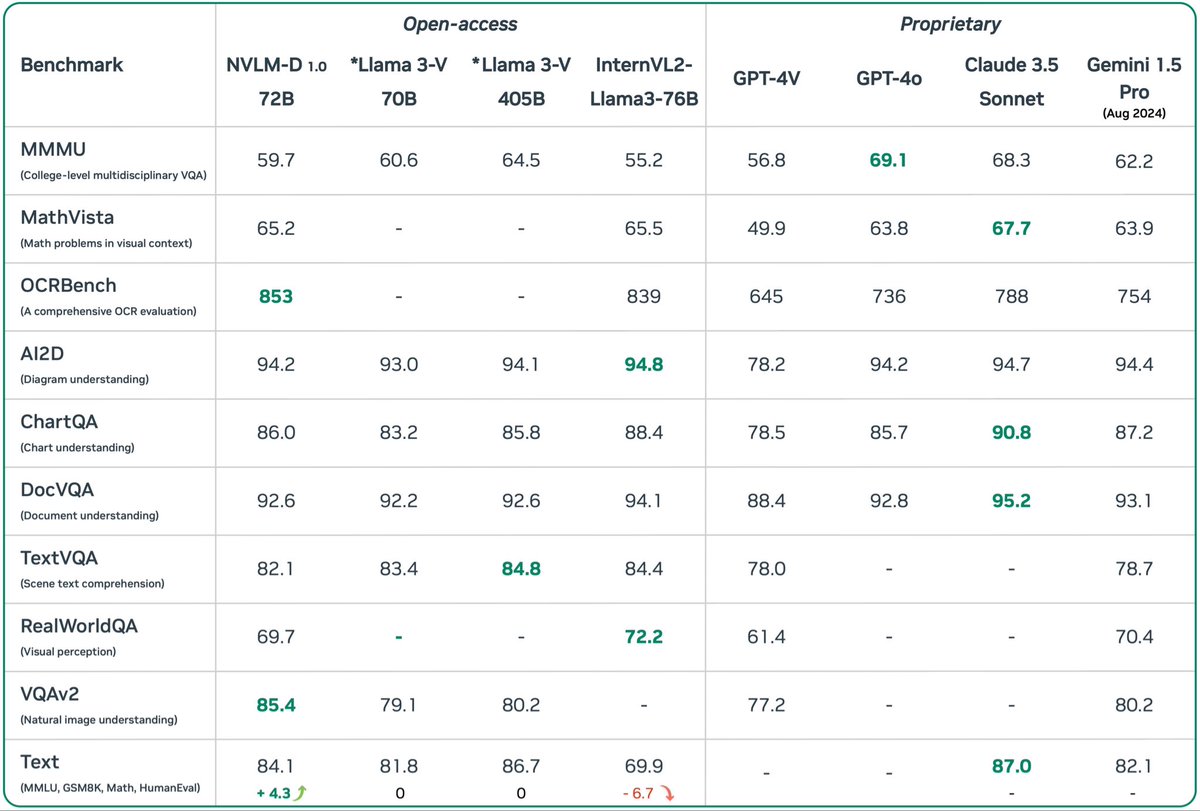

Nvidia推出了NVLM 1.0,一款顶尖的多模态大语言模型。这款模型在视觉和语言任务上表现优异,甚至能媲美市场上最先进的专有模型(如GPT-4o)和开放访问模型(如Llama 3-V 405B)。令人惊讶的是,经过多模态训练后,NVLM 1.0在仅文本任务上的表现也得到了提升。

该模型采用了一种全新的架构设计,结合了仅解码器多模态模型和基于交叉注意力的模型的优点,提高了训练效率和多模态推理能力。此外,引入了一维图块标记设计,极大地增强了高分辨率图像下的多模态推理和OCR相关任务的性能。

在数据方面,NVLM 1.0非常注重数据集的质量和任务的多样性,而不仅仅是规模。这使得模型在数学和编码能力上都有显著提升。

想象一下在自动驾驶汽车中的应用场景。NVLM 1.0可以通过摄像头实时获取道路信息,并与车辆导航系统进行语言沟通。它不仅能识别交通标志,还能理解复杂路况下的人类指令,例如“如果前方有施工,请寻找替代路线”。这得益于其强大的视觉-语言处理能力以及出色的文本推理能力,使得自动驾驶更加智能、安全、可靠。