解码神经网络的奥秘:从输入到输出的深度旅程

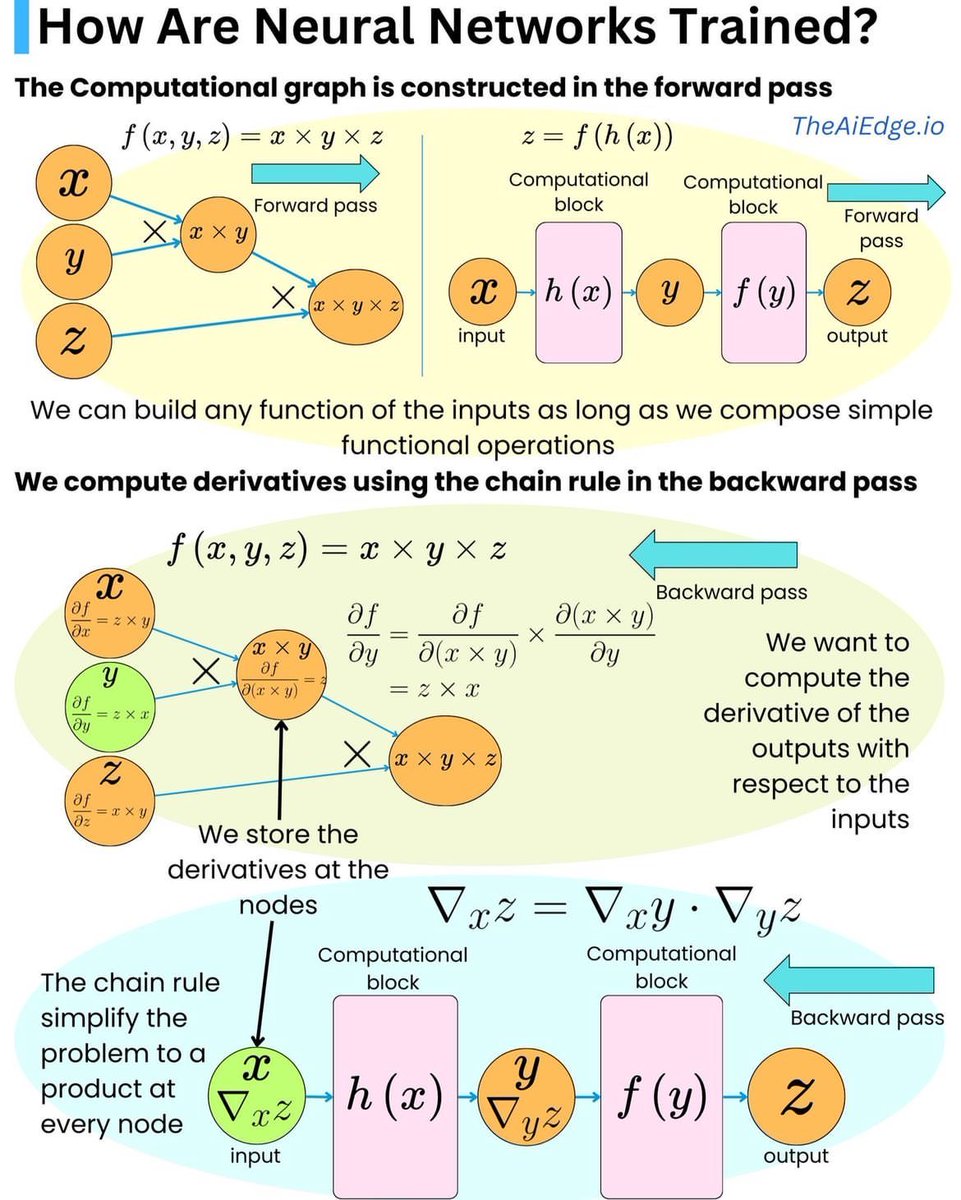

这张图详细展示了神经网络训练中的两个核心步骤:前向传播和反向传播。下面是对每个部分的详细解读:

前向传播(Forward Pass)

1. 计算图构建:

- 输入变量 \(x, y, z\) 被传递到计算图中。

- 计算函数 \(f(x, y, z) = x \times y \times z\)。

- 每个节点执行简单的数学操作,将输入组合成输出。

2. 计算模块:

- 输入通过多个计算模块,如 \(h(x)\) 和 \(f(y)\),逐步进行处理。

- 输出是经过一系列变换后的结果。

反向传播(Backward Pass)

1. 链式法则应用:

- 通过链式法则,计算输出相对于输入的导数。

- 这是为了优化网络参数,减少误差。

2. 导数存储:

- 在每个节点处计算并存储导数。

- 这些导数用于调整模型权重,使其更精确地拟合数据。

3. 简化问题:

- 链式法则将复杂的微分问题简化为在每个节点上的乘积运算。

- 这样使得梯度计算变得高效。

总结

通过前向传播,神经网络可以将输入数据转化为输出预测;而反向传播则通过梯度下降更新权重,从而提高模型的准确性。这种结合使得神经网络能够高效学习和适应各种复杂任务。