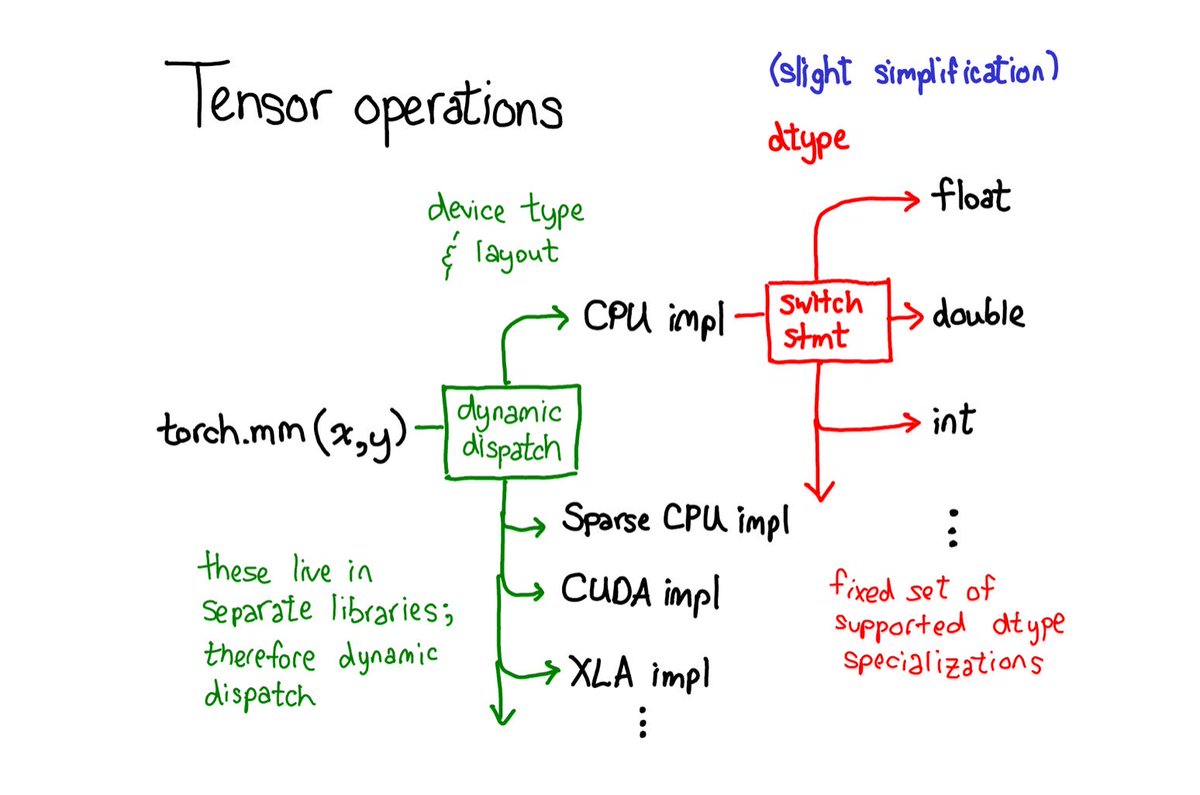

简单易懂的PyTorch张量操作流程

这张图展示了在使用PyTorch进行张量操作时,如何根据不同的设备类型和数据类型来选择相应的实现方法。对于机器学习工程师和开发者来说,这有助于理解PyTorch在后台是如何处理矩阵运算的。

1. https://t.co/aHKXAVVVka(x, y):这是个矩阵乘法操作,把两个矩阵 \(x\) 和 \(y\) 乘起来。

2. 动态调度(dynamic dispatch):这个步骤决定了该用哪个具体的实现方法。因为不同设备(比如CPU、GPU等)和不同数据布局有不同的实现,所以需要动态选择。

3. 设备类型和布局(device type & layout):

- CPU实现(CPU impl):如果你用的是CPU,就用这个方法。

- 稀疏CPU实现(Sparse CPU impl):如果数据是稀疏格式的,也有专门的方法。

- CUDA实现(CUDA impl):如果你用的是NVIDIA的GPU,就用这个CUDA方法。

- XLA实现(XLA impl):这是Google TPU等设备使用的方法。

4. 数据类型(dtype):

- switch语句(switch stmt):这里根据数据类型来选择具体的方法。

- float:如果数据是浮点数,就走这个路径。

- double:如果数据是双精度浮点数,就走这个路径。

- int:如果数据是整数,就走这个路径。

这些步骤确保了在不同硬件和数据类型下,PyTorch都能高效地执行矩阵运算。通过理解这些,可以更好地优化你的代码,提升计算性能。